Co to jest HDR10+? Dynamiczne metadane – kolejny etap w rozwoju technologii HDR i Ultra HD!

Rok 2017 stoi pod znakiem rozwoju formatów HDR. Duże zamieszanie w tym temacie mieliśmy już w ubiegłym roku, gdy okazało się, że na rynku mamy wschodzące trzy formaty: HLG, HDR10, oraz Dolby Vision.

Na chwilę obecną… mamy już aż sześć 🙂 Wymieńmy:

- HDR10

- HLG

- Dolby Vision

- HDR10+

- Technicolor

- Philips

Z taką mnogością wyborów nie spotykaliśmy się chyba jeszcze nigdy na rynku. Praktycznie zawsze wojny formatów sprowadzały się do wyboru jednego z dwóch, np. HD DVD vs Blu-Ray. Obecnie można dostać zawrotu głowy. Niektórzy producenci wspierają tylko jeden format, inni kilka na raz. W obecnej chwili nie ma ani jednego producenta, który jest w stanie zapewnić wsparcie dla wszystkich odmian HDR. W praktyce jednak nie jest aż tak źle, jak mogłoby to brzmieć. Spieszę z tłumaczeniem dlaczego!

Formaty HDR można by w praktyce podzielić na dwie gałęzie. Pierwszą z nich będzie HLG, czyli najprostszy format, którego przeznaczeniem są transmisje na żywo w TV. Jest on częściowo kompatybilny wstecz i wspierają go obecnie wszyscy wiodący producenci. Druga gałąź to formaty oparte na całkowicie nowym standardzie – HDR10. Cechują się one brakiem wstecznej kompatybilności i dają największe możliwości. Wszystkie “nowe formaty”, takie jak: Dolby Vision, Technicolor, Philips, oraz HDR10+ są jedynie rozszerzeniem formatu HDR10. W momencie gdy wyświetlacz nie jest kompatybilny z jednym z nich, to zawsze jest w stanie wyciągnąć “rdzeń” filmu w HDR10.

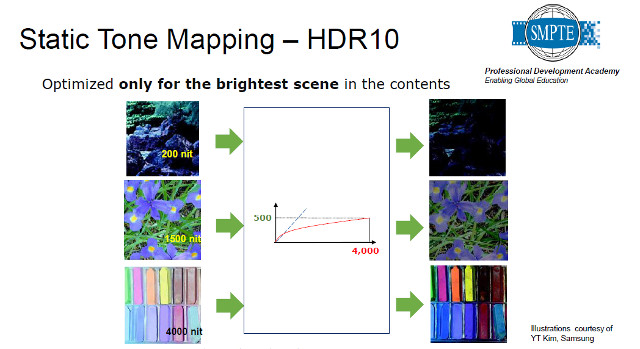

“Lepszość” wyżej wymienionych czterech formatów polega na bogatszych metadanych – informacjach przekazywanych do telewizora o jasności scen i o tym jak konwertować sceny, gdy ekran nie posiada wystarczającej jasności, by odtworzyć tak jak widział reżyser. W bazowym formacie HDR10 metadane są bardzo okrojone i wyświetlacz musi adaptować się do jednego, najbardziej jasnego piksela wśród bilionów innych pikseli w całym filmie.

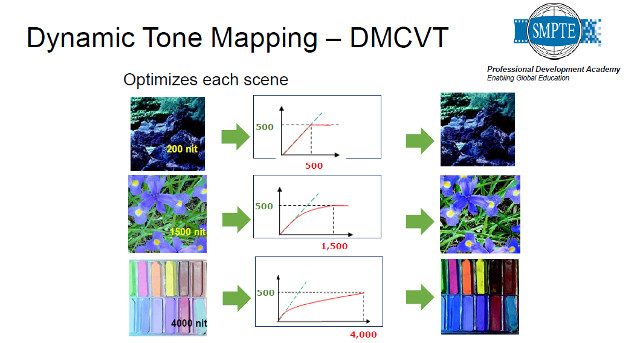

Pierwszą firmą, która postanowiła wyzbyć się tych ograniczeń stało się Dolby. Wraz ze swoim standardem Dolby Vision opracowali oni zestaw dynamicznych metadanych, które mogą być dostarczane do każdego piksela w każdej klatce obrazu. Dzięki temu ekran wykorzystuje cały swój potencjał w każdej chwili. Najlepiej obrazuje to poniższa grafika.

Na potrzeby stworzenia powyższej grafiki przyjęto dwa założenia: wyświetlacz konsumenta ma 500 nitów, zaś wyświetlacz reżysera aż 4 000 nitów. W sytuacji tej, gdybyśmy posługiwali się tylko standardem HDR10, to wszystkie klatki w filmie byłyby ciemniejsze względem swoich pierwowzorów, bo ekran kompresowałby odcienie, by zrobić miejsce dla tych, których nie może fizycznie oddać (ze względu na ograniczoną jasność) nawet w sytuacji, gdy w danej klatce obrazu nie byłoby takich odcieni! Przy użyciu dynamicznych metadanych niektóre sceny, jak np. kadr 1, mogą być oddane dokładnie tak jak sobie wymarzył autor, zaś inne mogą być kompresowane, ale mniej niż wymaga tego np. kadr nr.3.

Dynamiczne metadane wydają się więc krytyczne dla lepszego oddania zakresu tonalnego filmu i osobiście dziwie się, że nie zostały ustandaryzowane w zwykłym HDR10. Jak mówi jednak przysłowie “lepiej późno niż wcale”. Specyfikacja wszystkich czterech standardów, jak się okazuje, jest bardzo podobna. Opisuje ją dokument SMPTE ST2094. Potencjalnie oznacza to, że standard HDR10+, który jest wspierany przez firmę Samsung, Panasonic i […] pozwala uzyskać taką samą jakość co Dolby Vision, czy Technicolor. Różnice na pewno powstaną jednak z tytułu sposobu masteringu filmów. Standard DV oferowany jest tylko i wyłącznie w projektach wspieranych przez firmę Dolby, przy pracy na ichniejszym monitorze – Pulsar. HDR10+ jest za to standardem bez opłat licencyjnych. Prawdopodobnie każdy będzie więc mógł tworzyć filmy HDR10+. Jak historia pokazuje, to właśnie takie standardy z reguły wygrywają wojny formatów. Czy tak będzie też teraz? Czas pokaże. Na razie pozostanie nam czekać i cieszyć się, że w rzeczywistości są tylko dwie gałęzie norm HDR, więc wbrew pozorom z kompatybilnością wcale nie jest źle! Czekać jest także na co. Podczas zamkniętej konferencji, hostowanej przez firmę Samsung na targach IFA 2017 miałem okazję uczestniczyć w technologicznym demo, gdzie pokazywano różnicę pomiędzy HDR10, a HDR10+. Te same wyświetlacze i te same ustawienia, bez żadnego naginania rzeczywistości. Różnica była pokaźna. Prawdę mówiąc nie spodziewałem się aż takiej. Pewnie wynikało to z faktu, że materiał miał bardzo jasne piksele (mniemam, że do 4 000 nitów, lub więcej).

Gdyby ktoś jednak zastanawiał się, który wyświetlacz warto nabyć ze względu na posiadanie najlepiej rokującego na przyszłość standardu HDR, to odpowiem w ten sposób: należy zmienić tor myślenia. Film obejrzymy w wysokiej jakości nawet bez dynamicznych metadanych, a największą różnicę zrobią i tak fizyczne możliwości ekranu. Proponuję więc brać pod uwagę najważniejsze cechy takie jak: poziom czerni, wierność oddania barw, pokrycie szerokiej palety i jasność w HDR, a także kąty widzenia, czy jednorodność ekranu.