HDR, Co to jest HDR, HDR10 kontra Dolby Vision

Rejestracja obrazów cyfrowych, zarówno tych ruchomych (film) jak i statycznych (zdjęcie) polega na zliczaniu ilości światła, padającego na matryce światłoczułą kamery przez obiektyw. Tak zgromadzone dane zostają zapisane w pliku graficznym, lub sekwencji plików wyświetlanych po sobie, jeśli mamy do czynienia z filmem. Telewizor, lub projektor, na którym oglądamy następnie obraz ma za zadanie odwzorować te poziomy światła i stworzyć przed nami iluzję obrazu rzeczywistego. Każdy z nas wie jednak, że spektakl filmowy ustępuje znacząco obserwowaniu świata na żywo. Jedną z przyczyn tego stanu rzeczy jest fakt, że poziomy światła odwzorowywane na ekranie mają znacznie mniejszą dynamikę (tj. różnicę pomiędzy najciemniejszymi i najjaśniejszym punktami) niż to co widzimy na co dzień.

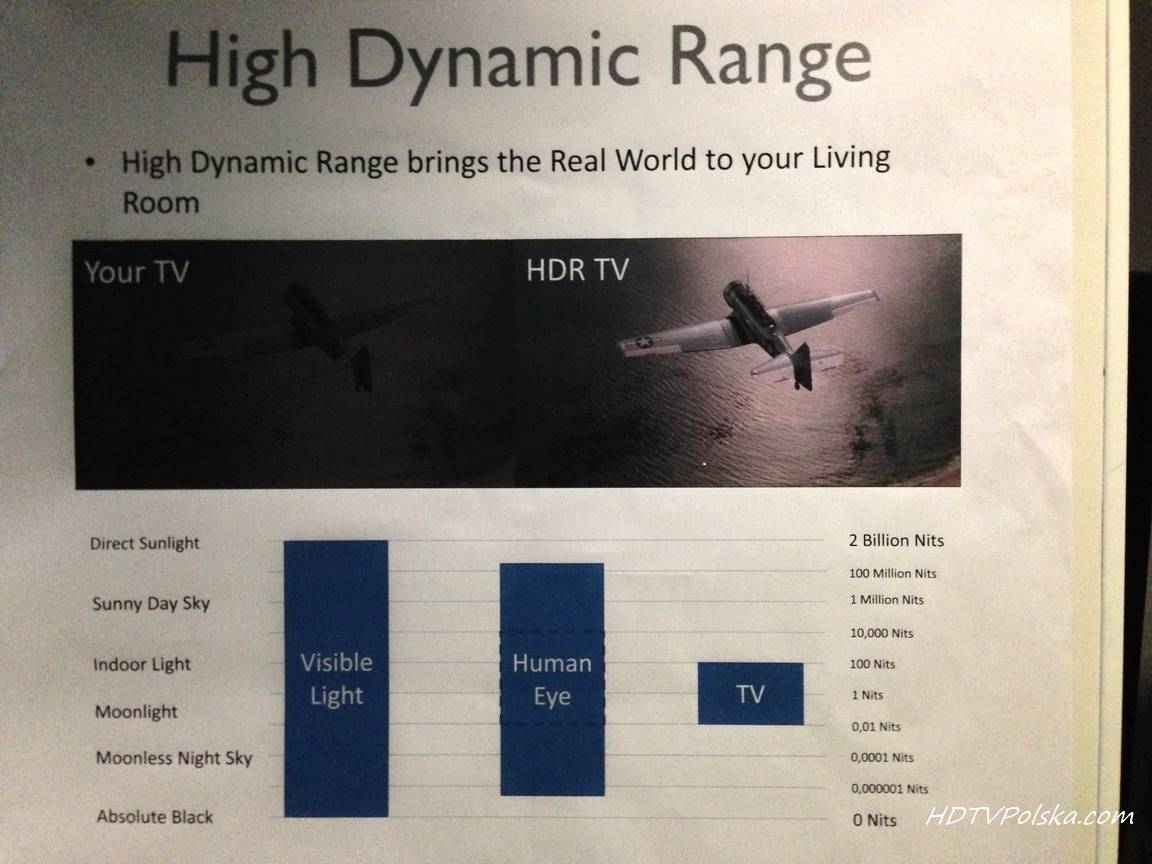

Przedmioty te mają w świecie codziennym znacznie wyższą jasność i wywierają znacząco inne wrażenie u widza. Żarówka (np. świetlówka kompaktowa) to około 20 000cd/m2. Księżyc na bezchmurnym niebie to 4 000cd/m2. Rekordzistą jest oczywiście słońce, którego jasność w południe przekracza 1 000 000 000cd/m2! Oczywiście patrzenie bezpośrednio na tak jasne przedmioty nie jest fizjologiczne naturalne i powoduje dyskomfort u widza. Jak jednak wspomniałem wcześniej, zazwyczaj obserwujemy przyćmione odbicia tych źródeł światła, które da się już komfortowo obserwować bez okularów słonecznych, a ich jasność jest wciąż wielokrotnie wyższa niż 120cd/m2 telewizora.

Czytelnik na tym etapie mógłby powiedzieć: „No tak, ale przecież telewizor można rozjaśnić”. Równie często słyszę: „I to jest ta nowość? Przecież ja tryb HDR mam już od dawna w aparacie w telefonie”. Zacznijmy od tego, że obie rzeczy nie mają w zasadzie nic wspólnego z przełomem jakim jest reprodukcja obrazu HDR. Wyświetlacze można rozjaśnić ponad 120cd/m2. To fakt. W naszych testach jasno widać, że niektóre z nich uzyskują bez problemu intensywność 400, czy nawet 500cd/m2 i to po kalibracji. Problem w tym, że rozjaśniamy obraz jako całość. Nie rozszerzamy tym samym informacji poziomach światła. W odniesieniu praktycznym – jeśli nagralibyśmy scenę z żarówką w ciemnym pokoju, to jedynym bardzo jaskrawym punktem miałby w niej być żarnik dający światło. Przy 120cd/m2 zdecydowanie nie będzie nawet podobny rzeczywistego, a po rozjaśnieniu całej matrycy do 500cd/m2 wszystko zrobi się zwyczajnie za jasne – nie zostanie zachowana ta proporcja między otoczeniem a samą żarówką. Raz, że nie będzie to naturalnie wyglądało, dwa bijące z całego ekranu (a nie z samej żarówki) światło będzie rażące dla widza. W pewnym więc sensie obrazy HDR przekazują znacznie więcej detali w bielach, a detale te są przeznaczone do wyświetlania na ponadnormatywnych (czyli ponad 120cd/m2, w ujęciu klasycznym) jasnościach. No dobrze, a co ze zdjęciami „w trybie HDR”? Zasadniczo nie mają one nadal za wiele wspólnego z tematem o którym rozmawiamy. Taka technika robienia zdjęć w istocie pozwala zarejestrować znacznie więcej detali w ciemnych i jasnych partiach obrazu (co pozwala obejść ograniczenia przetwornika w aparacie), jednak uchwycone detale są nadal mapowane w wąski zakres do wyświetlenia na klasycznym ekranie SDR. Uzyskujemy zatem „ładniejsze zdjęcie”, ale nie zawiera ono odcieni, do wyświetlenia w rejonie ponadnormatywnych jasności.

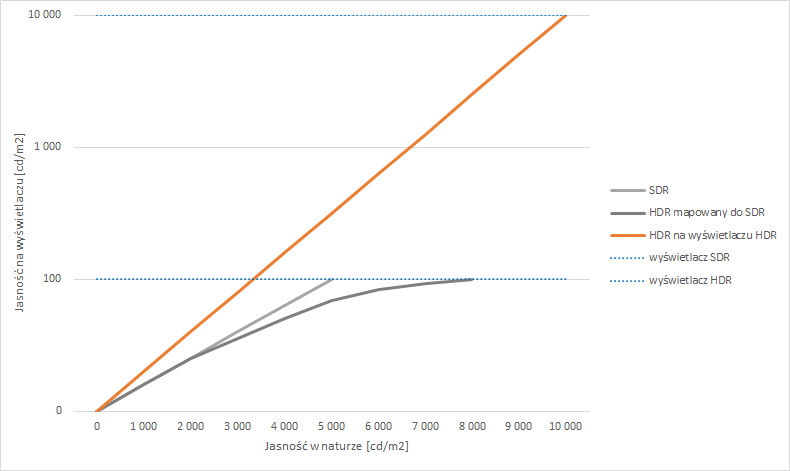

Mapowanie tonów jest w zasadzie kluczowym słowemem, którego chciałem uniknąć, aby utrzymać jak najprostszy wydźwięk artykułu. Nie jest to jednak możliwe. Skupmy się więc jeszcze na chwilę i przejdźmy do teoretycznego objaśnienia sytuacji na wykresie, a zrozumienie przykładów praktycznych stanie się później prostsze.

Powyżej przedstawiłem właśnie to co opisałem wcześniej słowami. W prawdziwej technice HDR, z którą związany jest właśnie przełom obecny na rynku, jasność nagrywanych przedmiotów odpowiada niemalże poziomom jasności reprodukowanym przez ekran. Oczywiście nie zawsze jest to relacja jeden-do-jednego, ale bardzo jej blisko do dosłownego przelania rzeczywistości na ekran. Nie można tego powiedzieć o technice SDR, gdzie jasność przedmiotów jest wielokrotnie niższa niż to co widzimy na telewizorze, a także pewne zakresy jasności nie są już w ogóle uchwycone. Chciałbym tu podkreślić słowo wielokrotnie, bo na diagramie oś Y jest logarytmiczna, więc to co się wydaje trzykrotnością na wykresie, to tak naprawdę 100 razy wyższa jasność! Uściślę jednak, że oko nie jest organem reagującym tak samo na stałe zmiany światła. Innymi słowy działa nieliniowo, więc 100 krotny wzrost intensywności światła, powoduje mniej więcej 20-25 krotne wizualne rozjaśnienie.

Wartość 10 000cd/m2 nie wzięła się na wykresie znikąd – dokładnie tyle przyjęto w nowych standardach jako górną granicę jasności. Obecnie spotykamy się z dwoma: bazowy – HDR10, oraz nieco bogatsza wersja – Dolby Vision (DV). Omówię je później. Wpierw zasymulujmy jak bardzo dużą różnicę może robić prawdziwy HDR. Oczywiście nie da się jej zobaczyć na stronie Internetowej, dopóki nasz monitor nie będzie wyświetlaczem HDR, a przeglądarka nie pozwoli na wyświetlanie takiej grafiki. Zastosowałem jednak inny „trick”.

Czy widzimy coś szczególnego w powyższym zdjęciu? Raczej nie. Zostało ono wykonane techniką HDR, by zachować jednocześnie detale pod gałęziami krzewu i w odblaskach na karoserii auta. Oczywiście następnie obraz został zmapowany do SDR by móc zostać wyświetlonym na monitorze – ten etap przebiegł jednak w szczególny sposób. Za górną granicę jasności przyjąłem 15cd/m2, czyli jakieś 6,5 raza mniej niż możliwości naszych monitorów. Spójrzmy teraz na to samo zdjęcie wykorzystujące cały przedział jasności

Robi ogromną różnicę prawda? Uświadommy teraz sobie, że to drugie zdjęcie jest także w pewien sposób „obcięte” i wszystkie odblaski wyglądały by nieporównywalnie inaczej w prawdziwym HDR o wymiarze 10 000dc/m2. Teraz zobaczyliśmy różnicę zarówno 6,5x jasności, a nowy standard to aż 100x więcej!

Co mogą wyświetlacze?

Potencjał 10 000cd/m2 jest oczywiście tym na co pozwala standard maksymalnie. W obecnej chwili żaden wyświetlacz nie ma możliwości wygenerowania aż tak wysokiej jasności. Sprawdzanie maksymalnej luminancji jest częścią naszej procedury testowej (. Mierzy ją też konsorcjum UHD Alliance, nadając certyfikat Ultra HD Premium. Teoretycznie gwarantuje on, że telewizor zdolny jest pokazać 1 000cd/m2. To dziesięciokrotnie mniej niż maksimum, ale także dziesięciokrotnie więcej niż to co oglądaliśmy przez lata w telewizji. By przyznać certyfikat UHD Premium wystarczy zmierzyć jasność na białej planszy o niewielkim rozmiarze, co jak się okazuję nie zawsze przekłada się na sprawność w filmach.

Z tego względu wprowadziliśmy nasz autorski system pomiarów HDR, który ocenia rzeczywistość w postaci filmów a nie tylko plansze testowe. Całą procedurę opisałem dokładnie tutaj

W studiach zaś goszczą standardowo wyświetlacze o jasności 600cd/m2 (Dolby PRM-4220) i 700cd/m2 (Sony BVM-X300) zgodne z HDR. Filmy, jak zbadaliśmy przenoszą jednak jasności nawet tak wysokie jak 4000cd/m2. Ich obróbka przebiega najprawdopodobniej na prototypowych wyświetlaczach Dolby Pulsar, posiadających taki potencjał.

Dolby Vision vs HDR10

Jak wspomniałem wcześniej, w obecnej sytuacji mamy na rynku dwa konkurujące standardy HDR. To podobna sytuacja do np. walki Blu-ray vs HD-DVD, czy kaseta VHS vs Betamax. Bazowym standardem, w jakim wydawane są na razie pierwsze filmy Ultra HD Blu-ray jest HDR10. Nie wykluczone jednak, że mogą pojawić się także filmy z Dolby Vision na nośnikach fizycznych. W obecnej chwili te drugie spotkać można w serwisach strumieniujących treść. Mam tu na myśli głównie Netflix. Różnic pomiędzy standardami jest bardzo dużo od tzw. kuchni. Dolby oferuje wsparcie dla domów postprodukcyjnych, dostarcza własny workflow masteringu treści. To jednak nie ma większego znaczenia dla nas – konsumentów, dla których liczy się przede wszystkim jakość treści, a nie to w jaki sposób powstawała. Tutaj DV ma także przewagę w postaci – słowo klucz – dynamicznych metadanych.

Metadane to informacje, które są niezbędne dla wyświetlacza by mógł on wyświetlić poprawnie treść. Najważniejsza z nich to tak zwany MDL (mastering display luminance), czyli parametr mówiący jaka była jasność monitora na którym film powstawał. Jeśli wszystkie wyświetlacze na rynku miałyby jasność 10 000cd/m2 to parametr ten nie byłby potrzebny wcale, bowiem każdy telewizor byłby w stanie wyświetlić tyle ile potrzeba. Jak jednak napisałem wcześniej, w 2016 roku łatkę premium dostaje model, który zapewnia tylko 1/10 maksymalnego potencjału (i nie dziwne, bo i tak jest to bardzo trudne). Wyświetlacz musi zatem wiedzieć w jaki sposób mapować tony, które przekraczają jego potencjał. Mógłby ich oczywiście zwyczajnie nie pokazać, ale jak się okazuje nie jest to takie proste. Ucięcie tonów na pewnym pułapie wygląda mniej więcej tak:

Takie plamy w jasnych obszarach zdecydowanie nie wyglądałyby dobrze. Na szczęście mając parametr MDL, wyświetlacz może nieco oszukać z oddawaniem poziomów jasności, by nie wygenerować takich błędów jak na powyższym obrazku. Przyjmijmy teraz, że nasze „pseudo-HDR” zdjęcie chcemy wyświetlić na ekranie Ultra HD Premium, który zapewnia maksymalnie 1 000cd/m2. Przyjmijmy także, że ta konkretna scena ma maksymalnie 1 500cd/m2 w odblaskach, ALE w filmie występują także sceny o światłach o wartości do 4 000cd/m2. Tu zaczynają się schody. Standard HDR10 przypisuję pojedynczą wartość MDL dla całego filmu, a bogatszy Dolby Vision precyzuje ją niezależnie dla każdej klatki. Co to oznacza? Mniej więcej tyle, że przyjmując hipotetyczną sytuację, którą opisałem powyżej (i która jest przykładem z życia), telewizor będzie „oszukiwał” także takie sceny, które mógłby oddać wiernie. Nawet takie ujęcie z samochodem, które prawie łapią się w zakres jego możliwości będą już mocno „skompresowane”, ponieważ w filmie występują ujęcia o wyższych jasnościach (MDL precyzuje 4 000cd/m2). Gdybyśmy natomiast mieli ten sam film w Dolby Vision, to wszystkie sceny, łapiące się w możliwości telewizora, zostałyby wyświetlone z perfekcyjną zgodnością, a „skompresowane tony” miałyby jedynie te wykraczające poza możliwości (o MDL wyższym niż 1 000cd/m2). Spróbuję zasymulować to wizualnie.

Przypomnę więc raz jeszcze nasz scenariusz – wyświetlacz 1 000cd/m2 (typowy high end 2016 roku), film 4 000cd/m2 (jest kilka takich pozycji na Ultra HD Blu-ray), ale w tej scenie jest maksimum 1 500cd/m2.

HDR10:

Jak widzicie różnica w tym przypadku może nie powalać na kolana, jednak zdecydowanie jest widoczna. Stopień tej widoczności będzie jednak uzależniony od możliwości telewizora i filmu jaki będziemy chcieli odtworzyć. Mając telewizor o potencjale 1 000cd/m2 niewiele tonów będzie musiało być kompresowanych obecnie, ale w niższych modelach różnica może być już ogromna. Podobnie może być gdy pojawią się filmy masterowane na jeszcze jaśniejszych wyświetlaczach, wtedy nawet tegoroczne telewizory z segmentu premium mogą okazać się niedomagające bez Dolby Vision, ponieważ będą silnie „naginać” większość scen, których w praktyce nie musiałyby. Tak się to przedstawia technicznie na wykresie:

Jak więc widzimy, dynamiczne metadane są bardzo ważnym elementem związanym z obrazowaniem HDR. W obecnej chwili wszyscy, którzy mieli okazję zobaczyć prawdziwą treść HDR na ekranie o dużym potencjale, są zachwyceni nową, przełomową, jakością przekazu. Wchodząc jednak w szczegóły, różnice między wyświetlaczami i formatami, okazuje się, że standard Dolby Vision, zapewniający tę funkcjonalność, jest w stanie dostarczyć efekt o lepszej jakości, szczególnie na wyświetlaczach o ograniczonym potencjale. W najbliższych latach będzie on więc robił dużą różnicę, ponieważ wyświetlaczy 10 000cd/m2 nie ma jeszcze na horyzoncie.

Mam nadzieję, że wyjaśniłem tym samym na czym polega rewolucja HDR i czym różni się ona od „zdjęć w trybie HDR”, a także dlaczego dynamiczne metadane są ważne i format, który je posiada (Dolby Vision) jest lepszy ![]()

Poproszę o uzupełnienie o HDR10+ który ma możliwość dynamicznej zmiany MDL tak jak DV ale, jaki będzie wynik (różnice) wyświetlanego obrazu streamowanego w standardzie DV (Netflix) na ekranie OLED (takie same matryce) ale jedna z HDR10+ a druga z DV?