-

Liczba zawartości

2 740 -

Rejestracja

-

Wygrane w rankingu

15

Odpowiedzi dodane przez misfit

-

-

-

Tak jak Ci pisałem na innym forum Optimiser jest też obecny m.in. w UB420/UB820, ale w tegorocznym UB450 już nie.

Jeśli chcesz koniecznie odtwarzacz z obsługą DV bo może kiedyś Ci się przyda to pod tym względem odradzam odtwarzacze Sony bo implementacja DV w nich woła o pomstę do nieba - przełączanie się pomiędzy odpowiednimi trybami SDR/HDR10/DV nie odbywa się automatycznie i domyślnie wszystko jest konwertowane do DV. Może kiedyś to poprawią poprzez aktualizację oprogramowania, a może nie.

-

1

1

-

-

1 godzinę temu, orwell-1984 napisał:Zrozumienie problemu zerowe, poziom żenujący. Podkręcanie jaśności w OLED, może gammę też sobie podkręć, popatrz na jasne obszary przy okazji

Właśnie po raz kolejny udowadniasz wszystkim, że nie masz zielonego pojęcia o tym o czym piszesz i nie miałeś nigdy do czynienia z HDR skoro nie rozumiesz tego, że podświetlenie w trybie HDR ustawia się na maxa. I to nie tylko w OLEDach.

-

1

1

-

3

3

-

-

To fajnie, że masz telefon z ekranem OLED. Ja mam od ponad roku co dzień telewizor OLEDa LG C7 i mogę w bardzo prosty sposób zweryfikować czy gubi detale czy też nie np. rozjaśniając na monitorku dany problematyczny kadr filmu tak aby wydobyć z niego wszystkie detale znajdujące się w ciemnych obszarach obrazu i porównać to z czym widzę na moim OLED. I na tej podstawie mogę z całą stanowczością wysnuć wniosek, że u mnie nie ma żadnego gubienia detali w cieniach.

Po drugie - suwakiem jasności ustawiamy poziom czerni telewizora więc oczywistym jest, że zmniejszając go poniżej optymalnej wartości tracimy detale w czerniach. Dotyczy to każdego rodzaju wyświetlacza. Natomiast to suwakiem podświetlenia zmieniamy jasność telewizora i w HDR powinna być ona na maxa.

Po trzecie - gdyby mniejsza jasność szczytowa wyświetlacza oznaczała mniej detali w ciemnych partiach obrazu (totalna bzdura) to we wszelakich profesjonalnie urządzonych shootutach gdzie porównuje się skalibrowane telewizory w zaciemnionym pomieszczeniu (gdzie jak na tacy widać czy jakiś wyświetlacz gubi detale w cieniach) to 1500 nitowe (i jaśniejsze) LEDy powinny wygrywać sromotnie z 700 nitowym OLED. A dziwnym trafem jest jakoś na odwrót.

3 godziny temu, orwell-1984 napisał:. I nie wszyscy o tym wiedzą o czym świadczy np. powyższy, typowy wpis internnetowego mądrali.

Lepiej być internetowym mądralą niż teoretykiem-bajkopisarzem, któremu dodatkowo brak elementarnej wiedzy.

-

1

1

-

1

1

-

-

O gubieniu detali w cieniach piszą praktycznie tylko osoby, które OLEDa nigdy nie miały lub widziały go co najwyżej w sklepie.

A co ma jasność szczytowa telewizora do widoczności detali w ciemnych scenach ? Absolutnie nic.-

2

2

-

1

1

-

1

1

-

-

3 godziny temu, Maciej Koper napisał:W kwestii DV dochodzi licencja od każdego wyprodukowanego odbiornika, która rzekomo kosztuje w przeliczeniu na nasze ponad 3zł, więc nie jest to już taka groszowa sprawa jak z HDR10+.

Dokładnie. W zależności od klasy telewizora oznacza to od ~0.02% do ~0.1% jego ceny

Dla wielbiciela nowych technologii wzrost ceny telewizora o 3 zł nie ma żadnego znaczenia, ale brak lub obecność obsługi DV już tak. Całe szczęście, że taki Panasonic (i nie tylko) poszedł po rozum do głowy i w tegorocznych OLEDach wprowadził obsługę DV, do tego "tv-led", a nie te niskopoziomowe soniakowe nie wiadomo co

Dzięki temu mają dużą szansę, że przy następnym rozdaniu to u nich zostawię gotówkę.3 godziny temu, Maciej Koper napisał:Algorytm dynamicznego mapowania jest, ale nie jest perfekcyjny. Niestety mocno oszukuje obraz (często nadmiernie rozjaśnia). Przy HDR10+ efekty są przewidywalne. Przynajmniej w założeniu.

Owszem, nie jest perfekcyjny, podobnie jak DV... (chociaż taki miał być

)

)

Powiedzmy sobie jednak szczerze, dynamiczne metadane to była zajawka tak ze dwa lata temu, a nie obecnie gdy mamy wyświetlacze z dynamicznym mapowaniem tonów czy Panasowego Optimizera, który przy okazji nie ma negatywnego wpływu na ciemne obszary obrazu czy ogólnie APL.

Co do HDR10+ - słabo to widzę aby zwykły śmiertelnik odczuł, że ma do czynienia z czymś wyraźnie lepszym skoro Vincentowe oko ma problemy z wychwyceniem na OLED jakichkolwiek różnic w obrazie względem zwykłego HDR10. Nie pomaga w tego typu testach też to, że niemal wszystkie dotychczas wydane filmy w HDR10+ na UHD BD były masterowane na 1000 nitowym Sony BVM-X300 i z MaxCLL mniej więcej tej wielkości.-

1

1

-

1

1

-

1

1

-

-

Ano właśnie - to by się zgadzało z tym co twierdzi Vincent Teoh.

Nie twierdzę przy tym, że Dolby Vision to jest jakieś bóstwo, co prawda jestem bardzo zadowolony z DV na moim combo LG C7 + OPPO 203 i widzę u siebie szereg jego zalet, ale potrafię też przyznać, że Dolby popełniło i wciąż popełnia wiele błędów jeśli chodzi o implementację tego formatu w niektórych wyświetlaczach (np. Sony i jego ciemnica w trybie DV) czy odtwarzaczach - niemal wszystkie poza OPPO (i jego klonami) ucinają detale w obszarach z wysoką jasnością szczytową (wielka szkoda, że nie dowiemy się tego w testach odtwarzaczy na hdtvpolska) do tego stopnia, że lepiej wymusić HDR10 jeśli posiadamy TV z sensownym algorytmem dynamicznego mapowania tonów obrazu.

Chodzi mi tylko o równe traktowanie i jeśli w jakimś teście ganimy wyświetlacz X producenta za to, że nie ma on obsługi formatu HDR10+ to analogicznie traktujmy producenta Y który nie daje obsługi DV w swoim TV.-

2

2

-

2

2

-

-

26 minut temu, raus napisał:Bardziej niezrozumiałe jest to dlaczego LG nie dodaje obsługi darmowego HDR10+

Czy aby na pewno jest to darmowa zabawa z punktu widzenia producenta TV ?

Oficjalna strona hdr10+ - https://hdr10plus.org/license-program/CytatDisplay Manufacturer - Annual Administration $10,000

Może zapytasz czym jest te $10,000 rocznie dla takiego LG... Zapewne mniej niż na waciki, ale niemal to samo możemy odnieść do licencji na DV - z ich punktu widzenia są to groszowe sprawy, które i tak producenci przerzucają na konsumentów. I nie interesuje mnie specjalnie to, że z punktu widzenia Samsunga DV jest ich konkurencją.

Zadajmy sobie też pytanie - skoro HDR10+ to tylko i wyłącznie dynamiczne metadane, a LG C9 posiada całkiem niezły algorytm dynamicznego mapowania tonów obrazu, to co tak w praktyce LG traci poprzez brak obsługi HDR10+ ?-

1

1

-

-

Gmeru - wiem, że chodziło Ci o DV i HDR10+ ale ja piszę o HDR10 (bez plusa) i DV. Skoro inni mogli w 2016r dać obsługę DV to dlaczego Samsung nie może w 2017, 2018r. i 2019r. Dla mnie to jest jego wada od 2016r. a nie od 2019r. ale mniejsza z tym

-

2

2

-

1

1

-

-

Nie do końca to kupuję bo pierwsze telewizory z DV i HDR10 na pokładzie pojawiły się jakoś tak w 2016r. jeśli mnie pamięć nie myli. Skoro inni mogli to dlaczego nie Samsung ? Ale ok - przyjmuję do wiadomości Twój tok rozumowania.

-

20 minut temu, Gmeru napisał:W Q90R jest (chyba też kiedyś pisałeś od razu po wrzuceniu go)

Tak, zwróciłem Wam na to uwagę ponad miesiąc po opublikowaniu testu Q90R

PS. W testach modeli QLED z 2018r. cały czas takowej wzmianki o braku DV.

-

Niezmiennie zastanawia mnie dlaczego w wadach telewizorów OLED podawany jest brak obsługi HDR10+ jak ww. czy Sony AG9, a w testach Samsungów QLED (np. Q70R) w wadach nie znajdziemy braku obsługi DV.

-

3

3

-

2

2

-

1

1

-

-

58 minut temu, D4r3KS napisał:Swoją droga ma się pojawić madvr envy procesor do obrazy kto wie może to urządzenie + box na androidzie czy tam osmc/openelec da obraz lepszy od oppo bo z tego co mi wiadomo komputer pc z odpowiednio wydajna karta graficzna i madvr niszczy oppo.

Przesadzasz i to grubo. Są rzeczy w których madVR i odpowiednio mocna karta graficzna mają pewną przewagę nad odtwarzaczami stacjonarnymi np. jeśli chodzi o chromę czy upscalowanie obrazu, ale większość osób określiłaby te różnice mikroskopijnymi. madVR ma niewątpliwą przewagę jeśli chodzi o konwersję HDR do SDR, ale mało kogo to interesuje. Nie należy też zapominać, że komp nie puści Ci do wyświetlacza czy to DV czy HDR10+, nie zrobi Ci też konwersji HDR10 do DV - zrobi to natomiast OPPO czy ten chiński klon.

-

1

1

-

-

Ponadto w ostatniej wersji firmware w OPPO coś mieszali z DV i od czasu jego instalacji na swoim LG C7 nie spotkałem się jeszcze z problemem z ciemnoszarymi pasami w trybie DV o którym m.in. wspominał Maciej Koper przy okazji filmu Fate of the Furious - https://hdtvpolska.com/test-dolby-vision-vs-hdr10-na-lg-oled-z-ultra-hd-blu-ray/4/

Zakładam, że skoro M9702 korzysta z tego samego firmware to i jego dotyczy ta poprawka. -

Pisałem o tym. Problem z mkv i Atmosem/TrueHD ma miejsce gdy wcześniej odpalana była ścieżka dźwiękowa DTS/DTS-HD MA/DTS:X. Aby temu zaradzić wystarczy wybrać ścieżkę Dolby Digital, a następnie przełączyć się na TrueHD/Atmosa.

-

Szkoda Twojego czasu. Ten kanał to jeden wielki żart i nie ma nic wspólnego z tym jak obraz wygląda w rzeczywistości. W szczególności jeśli chodzi o kolorki czy jasność obrazu.

-

1

1

-

1

1

-

-

-

Wracając do tematu...

Niezbyt pochlebna recka tego odtwarzacza ze strony Vincenta.

-

1

1

-

-

2 godziny temu, orwell-1984 napisał:W 2K to ja mogę robić "postprodukcję" na moim 4 letnim kompie ? Nie nie robią wiochy i jak ich nie stać na kamerę to niech wypożyczą sobie sprzęt z prawdziwego zdarzenia od Japończyków ?

https://www.cinema5d.com/canon-8k-cinema-camera-first-official-footage/

https://nofilmschool.com/2015/09/canon-developing-8k-uhd-cinema-camera-120-megapixel-dslr-display

Koniecznie polecam poniższy filmik, może wrócisz wtedy z powrotem na ziemię

-

1

1

-

-

41 minut temu, orwell-1984 napisał:Powstanie film AVATAR 2 i wiele innych w 8K.

Nope.

Kontynuacje Avatara kręcone są Sony CineAlta Venice. Wiemy też, że w 48 fps.

Tutaj możesz sprawdzić specyfikację tej kamery -> https://pro.sony/ue_US/products/digital-cinema-cameras/venice#ProductSpecificationsBlock-venice

Imager mode:

3.8K 16:9, 4K 17.9: 1-60FPS

4K 4:3: 1-48FPS

4K 6:5, 5.7K 16:9, 6K 17:9, 6K 1.85:1, 6K 2.39:1: 1-30FPS

6K 3:2: 1-24FPSA to czy Avatar 2 w postprodukcji będzie skończony w 4K czy 2K to się dopiero okaże.

-

Nawet w takim USA od 2014r. widać regularny spadek sprzedaży filmów nie tylko na DVD, ale również na BD. Nawet rosnące zainteresowanie filmami UHD BD nie jest w stanie tego spadku zatrzymać i tylko po pierwszej połowie tego roku mamy spadek sprzedaży BD (liczonego razem z UHD BD) na poziomie -17% rdr. O Polsce z litości nawet nic nie napiszę...

Zdecydowanej większości wystarcza streaming i VOD i już powstanie formatu UHD Blu-ray należy uznać za spory sukces przy tak niesprzyjających warunkach dla treści najwyższej jakości A/V. I to jest najpewniej ostatni format jaki zobaczymy na nośnikach fizycznych na którym studiom filmowym chce się wydawać swoje filmy.

Kolejna sprawa to czy w ogóle potrzebujemy 8K w warunkach domowych... Ile filmów zyskałoby na tej wyższej rozdzielczości biorąc pod uwagę, że nawet w 2019r. zdecydowana większość filmów z blockbusterami włącznie i tak jest kończona w 2K, a te nieliczne produkcje, które mogą poszczycić się 4K DI i tak mają w ponad 90% vfx'y upscalowane z 2K. Ludziska są zainteresowani ich kupowaniem głównie za sprawą HDR i WCG - sam się do nich zaliczam i sobie je chwalę i zdecydowanie bardziej preferuję upscala z 2K w HDR od 4K w SDR. Nowy format miałby chociaż cień sensu gdyby oferował coś ekstra poza rozdziałką 8K. Tylko co to miałoby być ?

Póki co hamulcowym są wyświetlacze - w UHD BD mamy przecie Dolby Vision z 12 bitową głębią koloru, ale panele w naszych telewizorach są co najwyżej w 10 bit. W UHD mamy paletę kolorów Rec.2020 (póki co w 99% przypadków pełni ona rolę kontenera, w którym de facto siedzi DCI-P3), ale nawet hi-end'owe wyświetlacze konsumenckie mają jej pokrycie na poziomie 75-80%. W HDR10 i DV jasność szczytowa może dochodzić do 10 tys. nitów, ale nasze wyświetlacze mają ją zdecydowanie niższą. Itd. itp.

-

Tylko nie wydawaj na Joe Black na BD za wiele bo co prawda prezentuje się lepiej pod każdym względem niż na DVD, ale jak na dzisiejsze standardy to i tak jest słabo i temu filmowi przydałby się porządny remaster - jeśli Universal kiedyś zdecyduje się ten film wydać w UHD to się tego doczekamy.

-

43 minuty temu, Adam60 napisał:Żeby była jasność - to, że posiadam filmy na DVD to nie jest mój wybór tylko przymus bo po prostu nie ma na BD, nie wspominając o UHD...

https://www.dvdmax.pl/joe-black-blu-ray,art86350?abpid=1163&abpcid=89

-

1

1

-

1

1

-

-

16 godzin temu, orwell-1984 napisał:Ciekawe kiedy wypuszczą blu-raye z 8K.

Najprawdopodobniej nigdy.

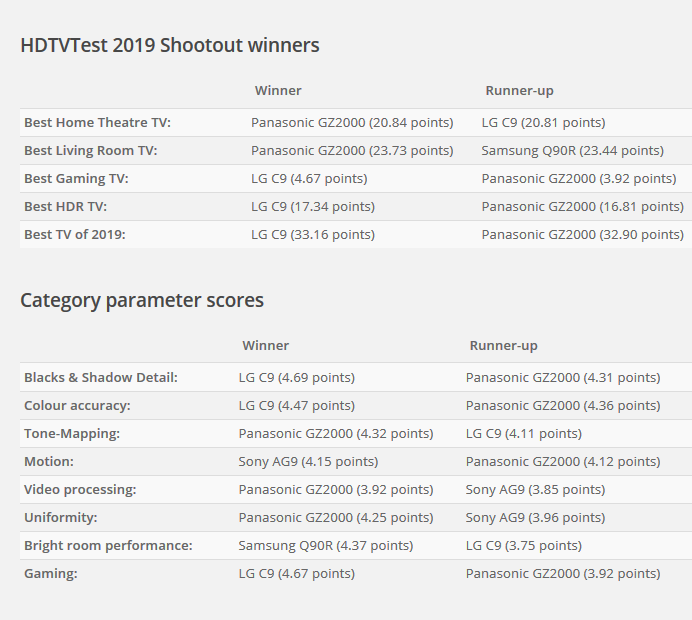

Publiczność wybiera najlepszy telewizor 2019 roku! Zaczynamy TV Shootout 2019 UK

w Co kupić i gdzie?

Napisano · Edytowane przez misfit

Odnośnie kolorków - w trakcie trwania imprezy obecny był profesjonalny monitor studyjny Sony BVM-X300 więc każdy mógł do niego podejść i porównać z obrazem generowanym przez resztę wyświetlaczy.

Kilka zdań dlaczego to LG C9 wygrał, również jeśli chodzi o odwzorowanie kolorków: