Miałem przygotowany komputer pod upgrade, ale nie do końca. Moja jednostka z procesorem Intel Core i5-10400F, 16 GB RAM-u i GeForcem RTX 3070 nieustannie dawała radę z najnowszymi grami w rozdzielczości 1440p. W moje ręce wpadł jednak Gigabyte NVIDIA GeForce RTX 4080 z 16 GB VRAM GDDRX6 i nie było czasu na zastanawianie się, czy procesor będzie sprawiać kłopoty, albo czy zmieści się do obecnej obudowy – na szczęście o zapas mocy w zasilaczu nie musiałem się martwić i jak się okazało, o miejsce w obudowie także. Nowa generacja Ray Tracingu i DLSS 3 już czekały na testy.

- PRZECZYTAJ TAKŻE: F1 23 – czy to najlepsza część od lat? Dużo nowego! Nasze wrażenia po rozgrywce na PS5

NVIDIA GeForce RTX 4080 jest w stanie pokazać pazur, nawet z bottleneckiem

Oczywiście, że GeForce RTX 4080 i leciwy Intel Core i5-10400F to nie jest idealne sprzętowe połączenie, ale trzeba pamiętać, że z im wyższej rozdzielczości korzystamy, tym moc coraz to nowszych generacji procesorów traci nieco na znaczeniu – szczególnie w 4K. W niższych rozdzielczościach niedopasowany wydajnościowo procesor będzie po prostu ograniczać widoczną liczbę klatek na sekundę – ale czy aż tak? Postanowiłem to sprawdzić przed wymianą swojego średniaka 10. generacji na coś mocniejszego z aktualnej, 13. generacji bazującego na Raptor Lake.

Okazało się, że Intel Core i5-10400F jest wciąż całkiem wydajnym układem i nawet wstrzymując się z wymianą procesora na nowszy, można po wymianie GPU odczuć spory wzrost wydajności w grach – nawet tych, które w dużej mierze korzystają z dobrodziejstw, jakie oferują nowoczesne CPU.

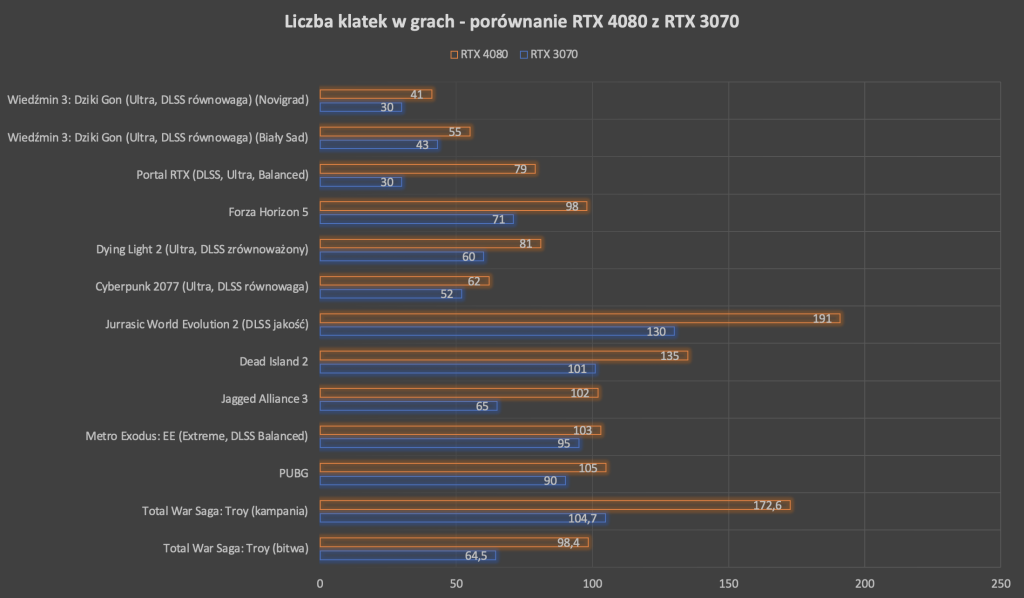

Jak widać wzrosty liczby klatek na sekundę w 1440p w większości ogrywanych przeze mnie tytułów były naprawdę spore, a tam gdzie wydajność polega w istotnym stopniu na mocy procesora – nie aż tak spektakularne (jak np. w PUBG).

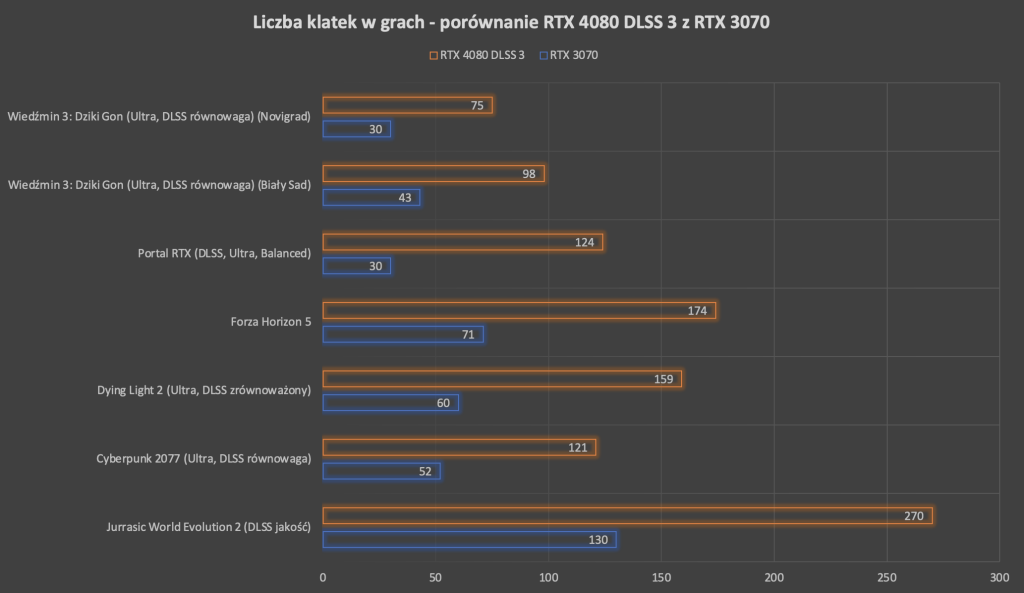

Trzeba jednak pamiętać, że karty GeForce RTX z serii 40 oferują wsparcie dla technologii DLSS 3. Sprawia ona, że gry ją obsługujące działają jeszcze szybciej. DLSS 1 i 2 była w stanie poprawić wydajność w grach dzięki skalowaniu obrazu bez większego uszczerbku na jakości obraz lub wręcz bez jakiejkolwiek straty. DLSS 3 poszło w tym kontekście jeszcze dalej – analizuje kolejno dwie klatki oraz dane ruchu i następnie generuje „bonusowe” klatki obrazu. Więcej na ten temat napisaliśmy w artykule o DLSS 3.

Jak więc wypadła przesiadka z GeForce RTX 3070 na RTX 4070 w grach, w których ten drugi mógł uwolnić swoje dodatkowe możliwości?

Wyniki mówią same za siebie – to jest przepaść. Co więcej, w przypadku Cyberpunk 2077 wzrost liczby klatek między modelem RTX 3070 (ustawienia Ultra, DLSS równowaga) a RTX 4080 ale z włączonym niezwykle wymagającym Path Tracingiem z DLSS 3 był praktycznie dwukrotny (101 kl./s.).

Czy było więc warto wymienić starszy model karty graficznej na GeForce’a RTX 4080 bez uprzedniego upgrade’u procesora? Oczywiście, że tak. CPU można zawsze wymienić w późniejszym terminie, jeżeli budżet pozwala aktualnie na zakup tylko jednego z tych sprzętów, a już sama podmiana karty graficznej na nowszy model potrafi przynieść spore korzyści.

Konsole i gry – przeczytaj więcej:

- Xbox wyprzedził PlayStation – oto nowa konsola Series S! Cena niestety powala

- Dysk do PS5… droższy niż konsola?! Tak – tyle zapłacisz za 4TB przestrzeni na gry

- Abonament PS Plus w mega ofercie – potężny rabat z okazji PlayStation Days of Play! Jak odebrać?

- System Shock – solidny remake, który włączysz nawet na starym komputerze! Udany powrót kultowego tytułu?

- Gdzie najtaniej kupić konsolę PS5 już za 2198 zł? Są nowe oferty w największych sklepach RTV w Polsce

Dziwne na moim 3070ti gram w 4k ale trzeba też iść na kompromisy w ustawieniach graficznych. Raczej na te chwile to Cyberpunk 2077 dał mi kopa tu musiałem na 1440p przejść grę.Nie jest idealnie ale się da

Jakie bzdury lol z rodziny 4000 jedyna dobra karta i naprawdę warta swojej ceny to 4090 reszta to szmelc a już 4070 to i non tu to badziewie kompletne. Ten artykuł to jawny sponsoring.

GPU się nie sprzedają to powstają takie testy

Nie namówisz mnie, mam 3070 i styka

Co ty bredzisz facet??? Ten procesor spokojnie obsłuży nawet 4090 bez żadnego problemu. Przypominam, że zwykła i3 10100F bez problemu w testach ciągnie 3080ti równo z i9 za 2 tyś zł. Leciwy? Rozumiem, że musicie reklamować sprzęt i wciskać kit dzieciakom, ale bez przesady. To nie jest “leciwy” procesor. Leciwy to jest i7 4790 który i tak do dziś dzięki ośmiu wątkom daje radę w najnowszych grach.

Jak dla mnie wielkim niedopatrzeniem jest 4080. Powinno być 4090. Różnica jest duża. Bawią mnie ludzie którzy robią taki zakup i nie dokładają dosłownie trochę żeby było dużo lepiej. Przy takiej przesiadce 4080 jest nie opłacalne. Jak dla mnie 4080 generalnie to jakaś pomyłka biorąc pod uwagę stosunek wydajność/ cena

4080 16GB vs 4090 24GB = przepaść. W cenie tej przepaści nie ma