-

Liczba zawartości

8 -

Rejestracja

-

Ostatnia wizyta

Odpowiedzi dodane przez czornyj

-

-

Każdy, kto kiedykolwiek usiłował popełnić zdjęcie aparatem cyfrowym lub analogowym wie, jak frustrujące jest rejestrowanie rzeczywistości przez szparę 8EV zakresu SDR, oraz jakie są konsekwencje wykonywania HDRów upchniętych w zakres SDR. Nie trzeba rozbłysków jądrowych, wystarczy okno w pomieszczeniu, krajobraz ze słońcem w tle, zacieniona uliczka - od razu szlag człowieka trafia, bo widzi pomieszczenie z oknem, a na zdjęciu wychodzi pomieszczenie z białą dziurą, albo okno otoczone czernią, niebo z czarną sylwetką krajobrazu, lub krajobraz z białym niebem, czerń w zacienionych partiach lub biel poza zacienionymi partiami. Kiedy zaczynamy kombinować i wciskać utraconą informację tonalną w zakres SDR uzyskujemy wypraną bladaczkę, a kiedy staramy się temu przeciwdziałać zwiększając kontrast śródtonowy, rażąco sztuczne rezultaty.

HDR to szersze otwarcie wrót percepcji, wyjście poza odwieczne ograniczenie znienawidzonych 8EV SDR, to okno z widokiem w "niespalonym" pokoju, zachód słońca na tle krajobrazu, a nie smoły, więcej detalu w cieniach i światłach. Nie chodzi o wypalanie oczu 10 tysiącami Candeli na metr kwadratowy, a wykorzystanie 14 działek EV informacji tonalnej rejestrowanych przez kamery cyfrowe, z których obecnie 6 działek jest po prostu przycięte zakresem SDR. To również efekt większej głębi, przestrzenności, trójwymiarowości bez okularów 3D. To nie jest kwestia nadmiaru dźwięku, hałasu i atakowania kakofonią bodźców, tylko zastąpienia tuby gramofonowej zestawem stereo.Kwestie standardów nie powinny stanowić w tym wypadku większego problemu, bo zapewne będzie je można stosować zamiennie w zależności od wsparcia ze strony posiadanego sprzętu, a efekt będzie nieco lepszy lub gorszy, ale tak czy owak zajedwabisty. Oczywiście upłynie jeszcze pewnie sporo czasu zanim branża nauczy się biegle władać nowymi narzędziami i umiejętenie je wykorzystywać, oczywiście obrazowanie to kwestia pozawerbalna i można ględzić o tym w nieskończoność na zasadzie rozmowy głuchego z ślepym o kolorach - ale zobaczymy, to pogadamy. Podobnie jak Maciek jestem pewien że nie będzie lipy, to akurat aspekt UHD o największym potencjale wizualnym, będący wisienką na torcie większej rozdzielczości i poszerzonego gamutu.

-

3

3

-

-

Bo wciąż, a to wynika wprost z Twojego tekstu, klienci sa robieni w trabę.

Z tekstu Maćka wynika, że inżynierowie obrazu - mając do dyspozycji wyświetlacze o coraz większych możliwościach - w końcu się wkurwili i postanowili przestać się trzymać kineskopowo-filmowo-kinowej rzeczywistości jak pijany płotu. Oczywiście zerwanie z obowiązującymi od wieków dogmatami wiąże się z poważnym skomplikowaniem sprawy, a doopska zabolą telewizje, kina i hollywoody, bo będą to musieli zaimplementować, a co gorsza zrozumieć, opuszczając bezpieczną piaskownicę z prostymi, znanymi zabawkami i utartymi schematami, które przez dziesięciolecia mogli bezpiecznie i bezmyślnie kopiować.

Pozwolę sobie - jeśli Maciek nie będzie mieć nic przeciwko temu - uzupełnić jego znakomity esej o swoje około foto/videograficzne przemyślenia

Wróćmy na chwilę do podstawy, jaką jest fotografia (film to praktycznie fotografia z dodaniem czwartego wymiaru), przypomnijmy pojęcie EV (Exposure Value), czyli wartości ekspozycji. Dla porządku uproszczę wszystko maksymalnie.

Wróćmy na chwilę do podstawy, jaką jest fotografia (film to praktycznie fotografia z dodaniem czwartego wymiaru), przypomnijmy pojęcie EV (Exposure Value), czyli wartości ekspozycji. Dla porządku uproszczę wszystko maksymalnie.

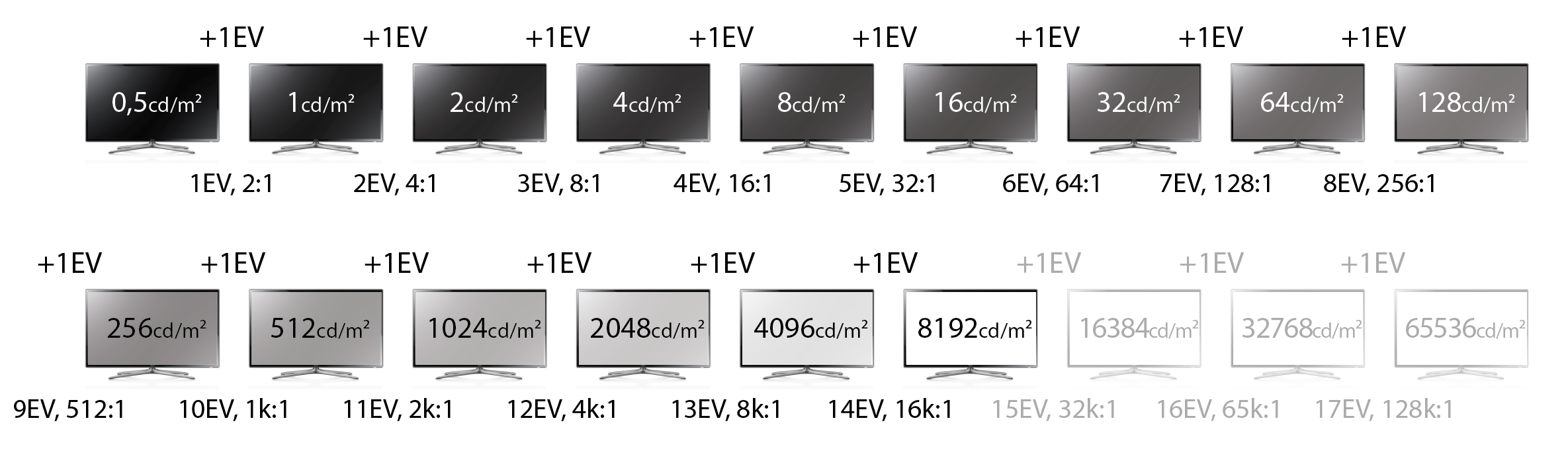

W fotografii zmieniając wartość ekspozycji (EV) o jedną działkę (one stop) uzyskiwaliśmy percepcyjnie równomierne rozjaśnienie bądź przyciemnienie. Jeśli coś np. miało wartość 2 działek EV, to było wizualnie "dwukrotnie jaśniejsze" od waloru o wartości 1 działki EV. Zakres dynamiczny monitora i najlepszej odbitki wynosił mniej-więcej 8EV i wartość ta stanowiła i stanowi do dziś podstawę - zdjęcia renderowane z postaci scene referred (światła sceny zarejestrowanego przez matrycę aparatu) do postaci output referred (optymalizowanej pod kątem możliwości reprodukcyjnych odbitki/monitora) mają zawsze ok. 8 działek-EVałek. Przeliczmy sobie nasze działki EV na cd/m^2 oraz CR (współczynnik kontrastu):

Wygląda znajomo? To właśnie (w uproszczeniu) ośmiodziałkowy zakres SDR o teoretycznej kontrastowości ok. 300:1, będący przez dziesięciolecia podstawą i wyznacznikiem wszechrzeczy, oraz powód, dla którego kalibrujemy wyświetlacze do 120cd/m² Niezależnie od tego, jaką realną dynamiką dysponowało medium służące do prezentacji treści foto/videograficznych, wyświetlany obraz był renderowany z rozpiętością 8EV. Popularne w fotografii obrazy HDR/DRI różniły się tylko tym, że zamiast wyciąć z dynamiki rejestrowanej sceny 8EV, kompresowały zakres większy od 8EV na zdjęciu o dynamice SDR, tj. wspomnianych 8EV. Obraz taki w efekcie staje się płaski, mdły i blady, dlatego aby skompensować to zjawisko stosuje się w zdjęciach tego typu zwiększenie kontrastu śródtonowego - rozjaśnia jasne obszary sąsiadujące z obszarami ciemnymi i vice versa, przyciemnia ciemne sąsiadujące z jasnymi.W tym momencie pojawia się jednak mała rewolta inżynierów obrazu, którzym obrzydło widać ograniczanie się do obrazów SDR w sytuacji, w której mamy do dyspozycji coraz jaśniejsze i bardziej kontrastowe wyświetlacze zdolne do prezentowania większego zakresu tonalnego. Spójrzmy zatem na rozszerzony zakres obrazowania HDR i zastanówmy się nad konsekwencjami tego posunięcia:

Każdy świadomy fotograf i videograf patrząc na powyższy wykres szybko zauważy związek pomiędzy faktem ustawienia maksymalnej luminancji na ok. 10000cd/m². Maksymalny zakres dynamiczny rejestrowany przez matrycę aparatu cyfrowego ograniczony jest przez rozdzielczość jej przetworników analogo-cyfrowych, przy czym z uwagi na liniowy sposób rejestracji światła daje to (w miarę) prostą zależność - ile bitów, tyle działek EV rejestrowanej dynamiki. W najnowszych matrycach stosowane są 14 bitowe przetworniki A/D, co daje 14EV DR, z czego ok. 12EV o dobrej jakości tonalnej, w przyszłości zapewne użyte zostaną 16bitowe A/D dające 14EV DR o dobrej jakości. Wyjście poza ten zakres wymagało by już filmowania na dwie kamery i nieziemsko jasnych wyświetlaczy, stąd w Rec.2020 stanęło zapewne na 10k cd/m² i 14 działkach EV.

Dla videofilów morał z powyższego diagramu to informacja, jaki wzrost maksymalnej luminancji jest potrzebny dla osiągnięcia realnie lepszej jakości wizualnego efektu, oraz jaki współczynnik statycznego kontrastu matrycy jest potrzebny, by przy danej maksymalnej luminancji dało się uzyskać odpowiednią jakość obrazowania (kontrast statyczny będący dwukrotnością maksymalnej luminancji). Ułatwi on również zrozumienie, że nie musimy koniecznie mieć wyświetlacza o luminancji 8tyś cd/m² oraz kontrastowości statycznej 16000:1 by cieszyć się wzrostem jakości wizualnej efektu HDR - już przy 250, 500, 1000cd/m² oraz kontrastowości odpowiednio dwukrotnie większej od danej luminancji uzyskamy 1-3 dodatkowych działek efektu HDR, co da nam konkretnego, wizualnego kopa!

Analogicznie - wcale nie potrzebne jest 100% pokrycie monstrualnego gamutu Rec.2020 by dało się zauważyć przepaść w jakości kolorystyki, ale o tym opowiem następnym razem

-

5

5

-

-

Nie dziwne, gdy sam Bóg koloru zostawia swoją odpowiedź

Warto by do niej także dołożyć trzy grosze o tak przyziemnych sprawach jak np. problem fotografowania wyświetlaczy, na których proces generowania obrazu jest dosyć rozciągnięty w czasie. Na przykład na plazmach, na telewizorach LCD z luminoforami GE PFS. Praktycznie nie idzie zrobić dwa razy takiego samego zdjęcia, bo aparat gromadzi różne etapy wyładowań światła.

Warto by do niej także dołożyć trzy grosze o tak przyziemnych sprawach jak np. problem fotografowania wyświetlaczy, na których proces generowania obrazu jest dosyć rozciągnięty w czasie. Na przykład na plazmach, na telewizorach LCD z luminoforami GE PFS. Praktycznie nie idzie zrobić dwa razy takiego samego zdjęcia, bo aparat gromadzi różne etapy wyładowań światła.Chyba "buk"

Innych problemów jest pewnie jeszcze sporo, np. z polaryzacją, charakterystyką kątową, defektami kolorymetrii addytywnej itp. itd.

No to może zostaje fotografować na błonie światłoczułej?

Pozdro

Zważywszy na fakt, że negatywy i diapozytywy zaprojektowano zanim wynaleziono białe LEDy i OLEDy katastrofalność ewentualnych efektów nietrudno sobie wyobrazić

Ten sam podstawowy problem co w fotografii cyfrowej, tylko zamiast senseli RGB mamy warstwy barwników CMY, brak balansu bieli i niestabilność kolorymetryczną negatywów wynikającą ze zmiany barwy maski w zależności od poziomu naświetlenia. Równie dobrze można użyć filmów monochromatycznych, było by to mniej bolesne...

Ten sam podstawowy problem co w fotografii cyfrowej, tylko zamiast senseli RGB mamy warstwy barwników CMY, brak balansu bieli i niestabilność kolorymetryczną negatywów wynikającą ze zmiany barwy maski w zależności od poziomu naświetlenia. Równie dobrze można użyć filmów monochromatycznych, było by to mniej bolesne... -

W epoce aparatu fotograficznego typu małpa albo ajfon tak już jest.

A wystarczy nauczyć się robić zdjęcia w trybie w pełni manualnym.

Wiedzieć co to jest balans bieli, ustawienie ekspozycji oraz czy mała czy duża dziura

.

.I przy porównaniach robić zdjęcia w identycznych ustawieniach manualnych.

Ot i cala filozofia. Polecam forum Nikoniarzy, tam jeszcze uczą jak robić dobre fotki

.

.aparat nie jest zawodny, zawody jest jedynie fotograf. ZAWSZE.

Ew. tester jak pisze Maceik, chcący przekłamać wyniki.

Jak to się mówi aparat fotograficzny jest odwzorowaniem rzeczywistości ... o ile ktos umie się nim posługiwać.

Pozdro

Sensele cyfrowego aparatu fotograficznego wyposażonego w matrycę z mozaiką bayerowską mają zupełnie inne krzywe uczulenia spektralnego niż czopki w siatkówce oka standardowego obserwatora. Z uwagi na to w aparatach stosowane są profile, które z grubsza redukują te przekłamania dla światła dziennego, z którym podświetlenie oparte na fluorescencji stosowane w telewizorach ma bardzo niewiele wspólnego. Warto też nadmienić, że profile aparatów nie są optymalizowane pod kątem wiernego odwzorowania barw, a uzyskania atrakcyjnego i przyjemnego wizualnie obrazu. W efekcie podczas fotografowania telewizorów aparaty łżą jak psy andaluzyjskie - paradoksalnie im lepsze, tym bardziej z uwagi na większą separację barw pociągającą za sobą większe przekłamania (gorszy SMI - indeks metameryzmu sensora).

Teoretycznie można oczywiście stworzyć profil korekcyjny optymalizowany pod fotografowanie telewizorów tak, by aparat rejestrował nieco mniej bezecne pierdoły, ale po pierwsze - taki profil będzie się sprawdzał tylko z konkretnym telewizorem, po drugie - telewizor taki musi oczywiście być do fotografowania idealnie skalibrowany, po trzecie - przekłamań i tak trudno będzie uniknąć, ergo tworzy się błędne koło, efekty będą mizerne, a bez sensorów i tak ani rusz. Rozwiązanie polegające na stworzeniu 3DLUT przy pomocy spektroradiometru i kolorymetru jest zatem o niebo sensowniejsze i dokładniejsze, choć nader upierdliwe i czasochłonne.

Gdyby byle jaki fotograficzny aparat cyfrowy obiektywnie odwzorowywał rzeczywistości, to:

- nikt nie używał by kalibratorów, bo wystarczyło by sfotografować telewizor i na bazie tego wprowadzić korektę

- w cyfryzacji dzieł sztuki nie używano by fotografii multispektralnej

- w astronomii nikt nie wykorzystywał by pixmap spektralnych, które przy rozdzielczości 10MPix mają rozmiar 5,8GB

- do tworzenia map nierównomierności wyświetlaczy nie używano by "aparatów cyfrowych" XYZ z matrycami o rozdzielczości... 1MPix (np. Konica-Minolta Sensing CA-2500) za drobne 20-30 tysięcy euro

Pozdrowienia z forum Nikoniarzy

-

10

10

-

-

Minusowy koordynat x oraz CCT... 60000K informuje nas, że najprawdopodobniej był to X-Rite i1Pro rev. A-D (pierwsza wersja i1Pro). Wygląda na klasyczny błąd pomiaru wynikający ze zbyt małej dynamiki tego sensora, prawdopodobnie mierzona próbka była na tyle ciemna, że w pomiarze było znacznie więcej szumu niż sygnału, stąd tak bezecnie bzdurny wynik. Zgodność międzyinstrumentowa spektrofotometrów tej serii to w praktyce średnio 1,5 pikowo 3∆E na wyświetlaczach szerokogamutowych, na to nakłada się błąd wynikający ze zbyt małej rozdzielczości widmowej przy pomiarze "piczastych" SPD - obawiam się, że błędy mogą w danym przypadku być znacznie większe niż 2∆E, szczególnie jeśli sensor uległ zabrudzeniu (które w tym modelu trudno wyczyścić).

i1Pro rev.E (wersja druga) ma już elektroniczną ekstrakcję szumu, do tego kompensację długości widma oraz dryftu termicznego, dzięki czemu znacznie lepiej radzi sobie z niskim poziomem sygnału, jest o niebo bardziej stabilny, łatwo go wyczyścić oraz ma dużo lepszą zgodność międzyinstrumentową. Ma jednak zdaje się nieco mniejszą FWHM od pierwszej wersji, co zwiększa ryzyko wystąpienia błędów pomiarowych przy "trudnych" iluminantach.-

1

1

-

-

Przedpremierowo powiem Ci, że gamut jest spory, ale nie jest też jakiś spektakularny. DCI pokrywa w 98%. Czerwień i zieleń praktycznie w punkt. Brakuje tych 2% w błękitach. Pasmo lasera niebieskiego jest bardzo wąskie, ale pozostały obszar w miarę płaski, bo drugi laser świeci przecież w luminofor.

Serdeczne dzięki - nie miałem jeszcze przyjemności pobawić się laserówką, nie wiem dokładnie jak i czym toto świeci, ale wyobrażałem sobie właśnie, że ma spory potencjał z uwagi na wąskie pasma

-

Niekontrolowanych warunkach?!

Przecież test był przeprowadzony w certyfikowanym (m.in. przez THX oraz Baselight) screening roomie. Trudno o jeszcze lepsze warunki. Oba projektory świeciły dokładnie z tego samego mastera DCDM (przeszło 2,5TB danych wideo). Nie było żadnych sztuczek po drodze. Osobiście dostarczałem przetwornik SDI -> HDMI żeby wpiąć Epsona, a zaraz po nim Christie. No i co najważniejsze, przed pokazem byłem trzy razy w tym miejscu, żeby skalibrować LS10000 do przestrzeni barwnej Christie, na czym spędziłem prawie 5 godzin.

Porównania były na wyrywkowo wybranych scenach z filmu.

Zapewniam Cię, że to było chyba najlepsze porównanie w historii premier urządzeń w tym kraju.

Dzień dobry wszystkim!

Maciek, czy przy okazji miałeś czas przeanalizować natywny gamut tego laserowca? Zakładam, Epson dysponuje większą przestrzenią barwną, zapewne trzeba go było "ciąć" by dopasować do Christie - sprawdzałeś jak wyglądało pokrycie DCI/Rec.2020 w jednym i drugim przypadku?

HDR, Co to jest HDR, HDR10 kontra Dolby Vision

w HD-Pedia

Napisano · Edytowane przez czornyj

Bo realnie w warunkach dziennych (kalibracja na 120cd/m²) światło otoczenia redukuje realnie postrzeganą głębię czerni, a wartość 0,5cd/m² i tak jest dość optymistyczna Realnie postrzegany kontrast i zakres dynamiczny łatwiej budować wyższą luminancją, bo nie wymaga ona tak wyidealizowanych warunków - nie musimy siedzieć w piwnicy wybitej czarnym aksamitem we wdzianku Dartha Vadera. Do tego bezwzględnie jaśniejsze bodźce są też nieco inaczej odbierane percepcyjnie.

Realnie postrzegany kontrast i zakres dynamiczny łatwiej budować wyższą luminancją, bo nie wymaga ona tak wyidealizowanych warunków - nie musimy siedzieć w piwnicy wybitej czarnym aksamitem we wdzianku Dartha Vadera. Do tego bezwzględnie jaśniejsze bodźce są też nieco inaczej odbierane percepcyjnie.

A po co miałby się połapać? To zmartwienie typów od postrprodukcji filmów, którzy będą przygotowywać materiał do wyświetlania/odtwarzania/emisji.

Dwa małe przykłady z wczorajszego spaceru

SDR - markizy rzucają cień, tworząc brzydką, czarną plamę na zdjęciu:

SDR rozjaśniony o 2 działki EV - rozjaśnienie otworzyło cień pod markizami, ale cała reszta stała się zbyt jasna:

HDR w SDR - całość zaczyna wyglądać sztucznie, mdło, płasko:

...i analogicznie...

SDR - wzgórze na tle nieba podczas zachodu słońca - wszystko chowa się w cieniu:

SDR rozjaśniony o 2 działki EV - sytuacja na wzgórzu staje się czytelna, ale niebo stało się białą plamą:

HDR w SDR - znów całość zaczyna wyglądać sztucznie, mdło, płasko:

HDR w HDR pokazałby w obu przypadkach informację w światłach i cieniach bez efektów ubocznych, dodatkowo zwiększając przestrzenność sceny i klarowność barw. Zważywszy, że potrzebne były tylko dwie działki EV, wystarczyłby do tego wyświetlacz o luminancji 500cd/m² i kontrastowości 1000:1, a więc żadne cuda.